关于robots.txt文件介绍

一、什么是robots;

robots是特殊用户访问的一种协议,像蜘蛛、机器等,有的站长不希望某个用户网站访问,就会设立robots协议,从而不能访问该网页;

通俗来讲,就是规定什么可以访问、那些东西你不能访问;

二、robots文件检查;

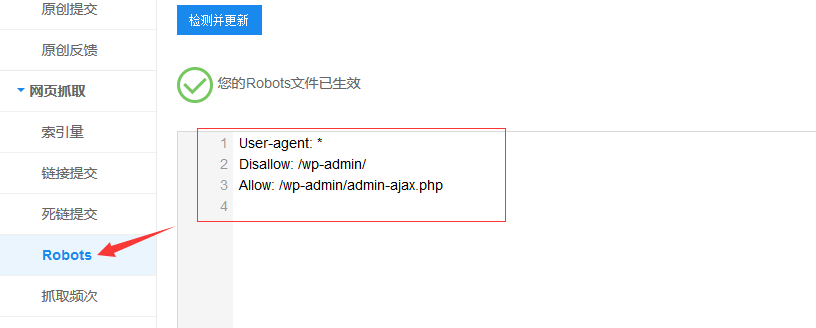

做SEO的人员会知道,当整个网站不能收录或目录下的页面不能够收录,而且过了很长时间都没有收录,这个时候你就得考虑是不是robots协议了,是不是禁止了蜘蛛爬取,百度站长可以检查的到;

如图; robots协议检查

三、robots原则;

搜索引擎服务于我们用户,但是对于现在互联网有太多的垃圾信息,或者是一些病毒,这是我们会考虑给它们设立一些原则; 尊重站长信息提供者的意愿,并且要尊重个人隐私; 每一个网站都要具有被保护的义务和隐私权利;

四、robots语法;

User-agent: * 这里的*代表的所有的搜索引擎种类,*是一个通配符;

Disallow: /admin/

这里定义是禁止爬寻admin目录下面的目录

Disallow: /.png$

禁止抓取网页所有的.png格式的图片

Disallow: /web/

这里定义是禁止爬寻web目录下面的目录

Disallow: /ABC123/

这里定义是禁止爬寻ABC123目录下面的目录

Disallow:/ab/adc.html

禁止爬取ab文件夹下面的adc.html文件。

Allow: /php/

这里定义是允许爬寻php目录下面的目录

Allow: /tmp

这里定义是允许爬寻tmp的整个目录

Allow: .htm$

仅允许访问以”.htm”为后缀的URL。

Allow: .gif$

允许抓取网页和gif格式图片

例1.

禁止所有搜索引擎访问网站的任何部分

User-agent: * Disallow: /

例2.

允许所有的robot访问 (或者也可以建一个空文件 “/robots.txt” file)

User-agent: * Allow: /

例3.

不允许蜘蛛爬取后台;

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

本文出自:琅枫个人博客。如需转载请注明出处!

本文出处:"https://www.langfujun.top/learn/other/49.html"

如果您觉得文章对你有帮助,可以进行打赏。

打赏多少,您高兴就行,谢谢您对琅枫博客的支持! ~(@^_^@)~

微信打赏

支付宝打赏